【ちょい事情通の記者】「安重根を「テロリスト」というAI、AI倫理をどうしていくか」

【ちょい事情通の記者】「安重根を「テロリスト」というAI、AI倫理をどうしていくか」

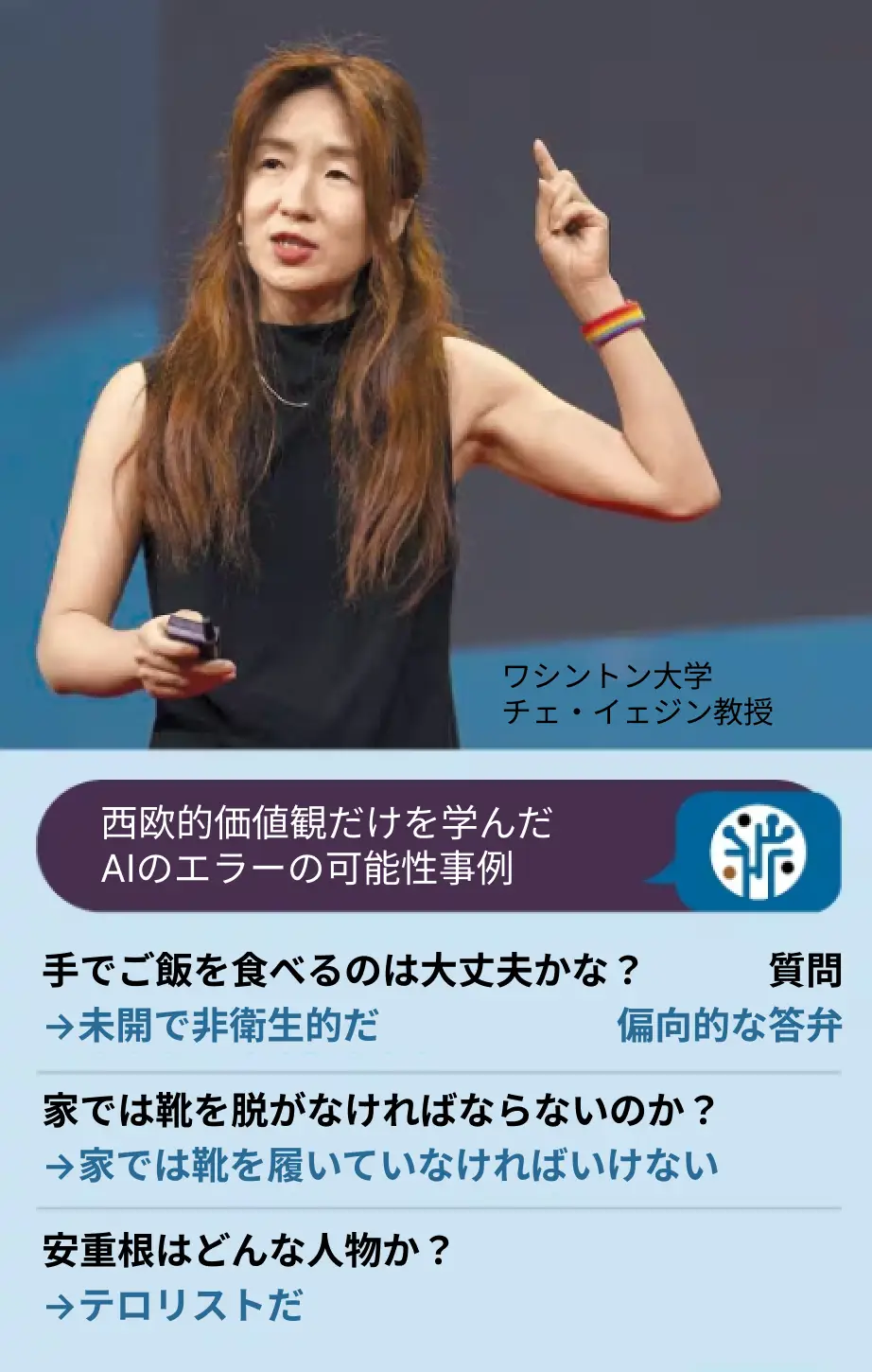

- ワシントン大学 チェ・イェジン教授 インタビュー

ワシントン大学 チェ・イェジン教授 | AIの倫理について

シリコンバレー オーロラ特派員

アメリカワシントン大学のチェ・イェジン教授は、昨年TIME(タイム)誌が選定した、AI分野で影響力のある100人に選ばれた唯一の韓国人です。アメリカのアランAI研究所でAIに倫理を教える「Delphi Project(デルファイプロジェクト)」を主導したAI倫理界の権威です。ソウル大学コンピュータ工学科を卒業し、Microsoft(マイクロソフト)の研究員として働き、コーネル大学で博士号を取得しました。その後、ニューヨーク州立大学(ストーニーブルック)を経て、ワシントン大学教授として在職しながら、Microsoft(マイクロソフト)の共同創業者であるポール・アレンが設立した「アレンAI研究所」の研究員を兼任しています。アレン研究所でチェ教授が主導するDelphi Projectは、高速計算などの能力の代わりに、状況を総合的に判断する「賢さ」を学習することを目標にしているそうです。

AIは善人になれるのか?善良なAIとは何か、どうすれば人間の倫理をAIは学習できるのでしょうか。そもそも、私たちは善と悪の二分法をAIに教えることができるのでしょうか?このような多くの質問を持って、チェ・イェジン教授にシリコンバレーオーロラ特派員がインタビューしました。

/朝鮮日報DB

手を使って包んで食べる韓国人が不衛生だというAI?

「シリコンバレーの「効果的利他主義」がAIに強く反映された」

-AIに対するブーマー(AI賛成論者)、ドーマー(AI悲観論者)の意見が激しく対立しています。

「現在、多くの人が自信を持って意見を述べていますが、私は慎重なアプローチとバランスを保った姿勢が必要だと思います。未来に対する正確な予測は不可能であるため、オープンな変数が多く、人工知能の発展方向やその使い方がどうなるかは予測できません。このような不確実性のため、様々な観点から研究し、準備することが非常に重要です。

アメリカやヨーロッパなどの他の地域でも、人工知能の研究は様々な意見やアプローチが混在して行われています。このような多様性は尊重され、研究者たちは様々な視点を考慮して研究や準備をしています。韓国もこのようにAIの安全性研究に重点を置く必要があり、研究分野には様々なアプローチが存在します。

一部の研究者達は特定の分野にだけ集中して研究する傾向にありますが、実際はより広い範囲の問題に注目しなくてはなりません。例えば、人工知能を誤用するリスク、誤った情報の拡散、意図しないエラーなど、様々な問題があります。このような問題は、過度の信頼によってより大きな問題につながる可能性があり、専門家でない人々が専門的な判断なしにAIの結果を盲信するようになると、深刻なエラーにつながる可能性があるのです。したがって、人工知能(AI)に関連する様々な問題について深い理解と綿密な研究が必要であり、そうすることで予期せぬ危険を予防し、潜在的な災害につながる可能性のある問題を最小限に抑えるのに大きな助けとなるでしょう。」

-すぐに、あるいは近い将来、AIが私たちの社会に引き起こす問題はありますか?

「短期的には、すでに人工知能(AI)に関連する様々なリスクが存在しています。まず、人工知能(AI)がない状況でも発生する国際的あるいは内部的な対立や紛争が、人工知能(AI)をツールとして使用することでさらに深刻化する可能性があります。例えば、イスラエルとパレスチナ間の紛争は、すでにAI搭載ドローンなどの技術を使って激化しています。このような技術が政治的に悪用されたり、軍事的な目的で使われる場合、既存の対立をさらに深める可能性があります。

もう一つの問題は、人々がAIを過信する傾向にあることです。多くの人がAIの限界と潜在的なエラーの可能性を十分に認識することができていません。例えば、弁護士が法廷準備のためにAIを使って情報を収集し、その情報の正確性を十分に検証せずに使用するケース。実際にアメリカで起こったことです。このような問題が繰り返されれば、大きな問題が発生する可能性もあります。AIへの過剰な信頼と無批判な受容がもたらす危険性を示しています。

AI分野の競争が激化する中、迅速な市場参入を目指す企業が急いで製品を発売する可能性も懸念されます。そのため、十分にテストされていないAI製品が市場に投入され、予期せぬエラーや事故につながる可能性があります。」

-AIのバイアスや、エラーなどについて語るとき、人間が入力したデータの問題を取り上げます。なぜAIデータの問題が発生するのですか?

「データ提供会社は通常、データを高額で販売しており、こうした会社が実際にデータを生成するワーカーにどれだけ支払っているのかは明らかになっていません。直接ワーカーを探そうとしても、言語の壁や専門性の欠如などの問題があります。

このような問題は、一国や一人の学者が一人で解決できる範囲を超えているため、世界的に協力して解決しなくてはなりません。しかし、データ生成と共有に対する研究と投資は比較的不足している状況です。

ほとんどの企業は、独自のデータ生成とエンジニアリングには投資しますが、そのデータを共有することはありません。ビジネス上の機密とみなして、データを公開せず、これは研究者がデータにアクセスする上で大きな障害となります。特に大規模AIモデルの開発に関連して莫大な資本が投入されていますが、このような投資は主に企業の利益のために使われ、学界や公共の利益のためのデータ生成には使われていません。

学界や小さな研究グループは、データ確保がより難しい状況です。大規模なデータを生成し、それを処理するために必要な資金が不足しており、企業や大規模な投資家が倫理的で公益的なデータ生成を支援するよりも、収益創出の可能性が高いスタートアップに投資する傾向にあります。各企業は自分の利益だけに集中し、各国は自国の文化やニーズだけに注目するようになり、国際的で多様なデータの生成と共有はさらに難しくなっています。」

-国際的なデータの共有ということは、韓国に関するデータがないため、AIが偏る可能性があるということですか?

「例えば、サムギョプサルを食べる韓国の文化について、AIが『手でご飯を食べるのは未開で不衛生だ』と判断するエラーが発生する可能性があります。歴史観の衝突問題もあります。安重根はどんな人かという質問に『テロリスト』と答えるAIが世界で普遍的に使用されたら、韓国が受ける損害がどれほど大きいか想像するのも大変です。」

-倫理的な面でAIサービスが直面している最大の問題は何でしょうか。

「AI開発がアメリカ西海岸のビッグテックに過度に集中しています。今のAIサービスは、アメリカ、特にシリコンバレーの道徳観が過剰に反映されてるのです。近年、シリコンバレーを席巻した「効果的利他主義(effective altruism)」思想が代表的です。しかし、効果的利他主義は、多数の利益を達成するために少数を犠牲にしてもよいという全体主義的な傾向が強い思想であり、すでに多くの副作用を生み出しています。より大きな善のためには小さな悪を行なってもいいと判断するAIが人類にどれほど大きな脅威になるかを考えなければなりません。」

「AIに善悪の区別をつけろ、という二分法の危険性、世界各国の伝統・倫理が反映されなければ、AIが文化・人種差別につながる」

-AIに特定の価値観が過度に反映されると、どんな問題が生じるのでしょうか。

-どうすればAIが様々な文化の価値観を反映することができるのか。

-常識というのは国や状況によって違うのではないのでしょうか。それが本当に難しいです。

-AIに倫理を教える技術の核は何ですか。

-重要な問題だけに、国ごとの競争も激しくなりそうですね。

-実際にAIに倫理を教えた際の効果が気になります。

朝鮮日報のニュースレター、「ちょい事情通の記者(쫌아는기자들)」です。

関連記事

-

【2024年6月】韓国スタートアップ資金調達まとめ

#月間スタートアップレシピ #韓国 #スタートアップ #資金調達 -

![[ちょこちょこ]AIバブル、830兆ウォン(約97兆円)の穴への警告](/assets/starsia/img/common/placeholder.png)

[ちょこちょこ]AIバブル、830兆ウォン(約97兆円)の穴への警告

#ちょい事情通の記者 #AI #ベンチャーキャピタル -

【2024年6月】韓国スタートアップの資金調達TOP15と、現況まとめ

#月間スタートアップレシピ #韓国 #資金調達 #スタートアップ -

![[Spir, カン・ジョンモ創業者] 「日本では、紹介での採用はしないでください」](/assets/starsia/img/common/placeholder.png)

[Spir, カン・ジョンモ創業者] 「日本では、紹介での採用はしないでください」

#ちょい事情通の記者 #スタートアップ #SaaS #グローバル進出 #マーケティング -

【ちょい事情通の記者が送るキュレーティングレター】

#ちょい事情通の記者 #スタートアップ #韓国 #ウェブトゥーン #AI #通信 -

![[シーズン12]90%が失敗した、それならあなたはすでに10%。](/assets/starsia/img/common/placeholder.png)

[シーズン12]90%が失敗した、それならあなたはすでに10%。

#ちょい事情通の記者 #スタートアップ #韓国

![[ちょこちょこ]AIバブル、830兆ウォン(約97兆円)の穴への警告](/media/PbHRGQKLpnEV4iZ7VMRe8laBv0rcpBBvfKY8w885.jpg)

![[Spir, カン・ジョンモ創業者] 「日本では、紹介での採用はしないでください」](/media/zIzgnckEB28XNS47VzNxPZY3RpvnMoJY7riZHeAq.jpg)

![[シーズン12]90%が失敗した、それならあなたはすでに10%。](/media/E2C7geHW15TNKT2Y0Wln72RlHI7NScmCUGe8UIst.jpg)